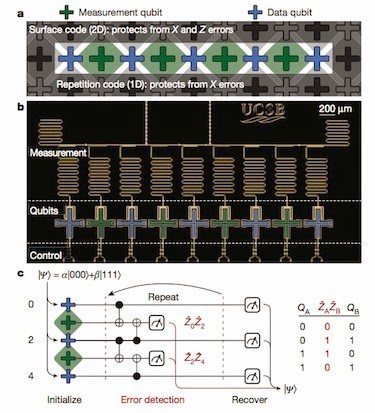

a) O código de repetição é uma

variante unidimensional (1D) do código de

superfície, e é

capaz de proteger contra erros (bit-flip). O código é implementado usando um padrão alternado de dados e medição de qubits. b)

Micrografia óptica do dispositivo quântico supercondutor, que consiste em nove qubits “transmon” com

controle e medição individual. c)

O algoritmo do código de repetição

utiliza repetidas operações de medidas e de emaranhamento que detectam

bit-flips, utilizando o

esquema de paridade no lado direito.

Usando o output a partir dos qubits medidos durante a

repetição do código para detecção de erro,

o estado inicial pode

ser recuperado removendo erros físicos no software. Texto e imagem: Nature

Os pesquisadores, liderados por John Martinis,

construíram um circuito quântico supercondutor que consiste em nove qubits.

Cada qubit é um pequeno circuito constituído por um condensador e um indutor

não-linear (chamado cruzamento Josephson), que atua como um átomo artificial.

Os materiais que compõem o conjunto são uma película de alumínio depositada em

um substrato de safira.

“Nosso sistema

de nove qubits pode proteger-se de erros de bits que inevitavelmente surgem do

ruído e flutuações do ambiente em que os qubits estão incorporados”,

explica o membro da equipe de Julian Kelly.

“Mostramos também que ‘mais é melhor’: nove qubits

protege o sistema melhor do que cinco qubits, um requisito fundamental quando

vai para mais qubits em um computador quântico real do futuro”.

Estados quânticos são frágeis

Os computadores quânticos vão funcionar com

base no princípio de que uma partícula quântica pode estar em uma superposição

de dois estados ao mesmo tempo – ‘spin up’ e ‘spin down’ no caso de um elétron,

por exemplo. Os dois estados representam um ‘1’ e ‘0’, de modo que N partículas

- os qubits - podem ser combinados, ou ‘emaranhados’, para representar valores

2N simultaneamente. Isso levaria ao processamento paralelo de informação em

grande escala, o que não é possível com os computadores convencionais.

Tais máquinas quânticas teriam um

desempenho muito melhor em determinadas tarefas, como a aprendizagem de máquina

ou simulação de moléculas complexas, por exemplo, porque suas velocidades de

processamento devem crescer exponencialmente com o número de qubits de informação

envolvidos. Na prática, porém, os físicos têm se esforçado para criar até mesmo

o computador quântico mais simples, porque a fragilidade desses estados

quânticos significa que eles são facilmente destruídos e são difíceis de

controlar.

Paridade de medição

“Na mecânica

quântica, não podemos medir um qubit sem destruir a superposição e

emaranhamento que faz com que a mecânica quântica funcione”, diz o

membro da equipa Rami Barends,

“mas podemos medir algo chamado paridade, que forma a

base da correção de erro quântico”.

Os pesquisadores exploraram esse fato e

repetidamente mediram a paridade entre ‘dados’ de qubits adjacentes, fazendo

uso de qubits de ‘medição’. “Cada ciclo, estes qubits

de medição interagem com seus qubits de dados circundantes, através de portas

lógicas quânticas e então podemos medi-los”, diz Kelly. “Quando ocorre um erro, a paridade muda de acordo e o qubit de

medição relata um resultado diferente. Ao acompanhar esses resultados, podemos

descobrir quando e onde ocorreu um erro de bit”.

Identificação e correção de erros

Um número maior de qubits fornece mais

informações para identificar e corrigir os erros, acrescenta Austin Fowler,

membro da equipe. “Erros podem ocorrer a qualquer

momento e em todos os tipos de qubits: qubits de dados, qubits de medição,

durante a operação da porta e até mesmo durante a medida. Descobrimos que um

dispositivo de cinco qubits é robusto para qualquer tipo de erro de bit que

ocorre em qualquer lugar durante um algoritmo, mas um dispositivo de nove qubits

é melhor porque é robusto para qualquer combinação de dois erros de bit”.

Embora ainda muito longe de aplicações no

mundo real, os pesquisadores dizem que um dispositivo de ‘auto-correção’ como o

deles poderia ser uma ótima plataforma para testar algumas das ideias por trás

da correção de erros - como proteger um estado quântico contra os famosos erros

de phase-flip. “Nós também estamos agora ocupados em melhorar a qualidade

dos nossos qubits e os materiais que usamos para fazê-los”, diz Kelly.

John Martinis

e vários outros especialistas descrevem os benefícios e desafios da computação

quântica em um podcast que apareceu pela primeira vez no site physicsworld.com: “A

computação quântica: Desafios, triunfos e aplicações”.